La crescita dell’IA generativa sottolinea l’importanza cruciale della qualità dei dati. Dal lancio di ChatGPT nel novembre 2022, il sito ha raggiunto 1,5 miliardi di visite mensili. Questo impatto ha attratto l’attenzione delle società finanziarie, portando l’IA a diventare una nuova frontiera per gli investimenti di private equity. Nel secondo trimestre del 2023, i finanziamenti in startup di IA generativa hanno raggiunto i 14,1 miliardi di dollari, un aumento significativo rispetto ai 2,5 miliardi del 2022.

È chiaro quanto sia fondamentale l’IA. Uno dei principali dibattiti riguarda la qualità dei dati e il suo impatto sui risultati dell’IA. Non si tratta di una preoccupazione nuova. Già nel 2018, uno strumento di recruitment dell’IA di Amazon mostrava pregiudizi contro le donne. I set di dati, basati prevalentemente su curriculum maschili, portavano lo strumento a declassare le candidature contenenti la parola “donna”.

Si è discusso molto dell’impatto della qualità dei dati sui risultati dell’IA generativa. Ma come possono gli sviluppatori garantire l’utilizzo dei migliori dati di addestramento per creare modelli di IA efficaci?

La qualità dei dati nell’IA: Quanto conta?

L’IA sta migliorando numerosi ambiti della società. I risultati preliminari nell’uso dell’IA per lo screening del cancro al seno mostrano che il carico di lavoro umano è quasi dimezzato. Tuttavia, i pregiudizi associati agli strumenti di IA, se utilizzati per assunzioni o per le forze dell’ordine, rimangono una preoccupazione significativa.

Le aziende devono adottare misure pratiche nelle fasi iniziali dell’implementazione dell’IA per ridurre le discrepanze. Gli algoritmi di IA, infatti, possono svolgere attività in modo più rapido ed efficiente, ma richiedono grandi quantità di dati per funzionare correttamente.

Un esempio recente è Octopus Energy, dove le e-mail automatizzate dall’IA hanno ottenuto un tasso di soddisfazione del cliente dell’80%, superiore del 15% rispetto all’intervento umano. Gli algoritmi di IA apprendono, analizzano dati e prendono decisioni basate su queste informazioni. Per fare ciò, l’IA necessita di grandi quantità di dati reperiti e utilizzati in modo etico.

Utilizzare dati provenienti da fonti diverse e rappresentativi dell’intera popolazione aiuta a mitigare pregiudizi e imprecisioni. Inoltre, creare team di ingegneria dei dati diversificati, che riflettano la varietà delle persone che utilizzano l’algoritmo, può ridurre i pregiudizi.

Tuttavia, tenere conto dei pregiudizi è più difficile con algoritmi di apprendimento non supervisionato. Difetti nei set di dati originali si manifestano nei modelli generati. Inoltre, la progettazione di strumenti per filtrare i pregiudizi può compromettere la qualità del modello. Sono in fase di sviluppo approcci alternativi per ottenere risultati migliori.

Seguire la folla o rompere gli schemi?

I metodi tradizionali di approvvigionamento dei dati, come l’etichettatura dei dati con descrizioni chiare o marcatori, si basano su pratiche consolidate. Questi metodi possono garantire risultati affidabili se la qualità dei dati è alta. Tuttavia, dati di scarsa qualità possono generare pregiudizi.

Abbandonare i metodi consolidati è spesso difficile. Per questo motivo, nell’ultimo anno molte aziende tecnologiche hanno iniziato a utilizzare modelli linguistici di grandi dimensioni (LLM) per l’analisi dei dati.

Gli LLM sono algoritmi di IA che impiegano il deep learning per classificare e categorizzare grandi set di dati in modo più efficiente. Grazie alla loro capacità di comprendere e generare linguaggio, gli LLM possono identificare discrepanze nei dati che potrebbero portare a risultati distorti.

Piattaforme LLM personalizzate si stanno diffondendo in vari settori, inclusa la cybersecurity. Ad esempio, Google ha lanciato Google Cloud Security AI Workbench.

Tuttavia, gli LLM possono essere manipolati se i dati di addestramento includono informazioni fuorvianti. Gli utenti possono avere difficoltà a verificare l’integrità dei dati di addestramento, poiché le informazioni disponibili sono spesso limitate. Nonostante ciò, è incoraggiante che queste tecnologie possano aiutare a identificare informazioni potenzialmente errate.

Essendo tecnologie in sviluppo, non è prudente abbandonare completamente le funzioni predittive tradizionali come l’etichettatura dei dati. I LLM potrebbero non comprendere completamente la complessità di alcuni dati o contesti, rendendo necessaria l’etichettatura umana per migliorare l’accuratezza.

La prossima normativa fornirà una risposta?

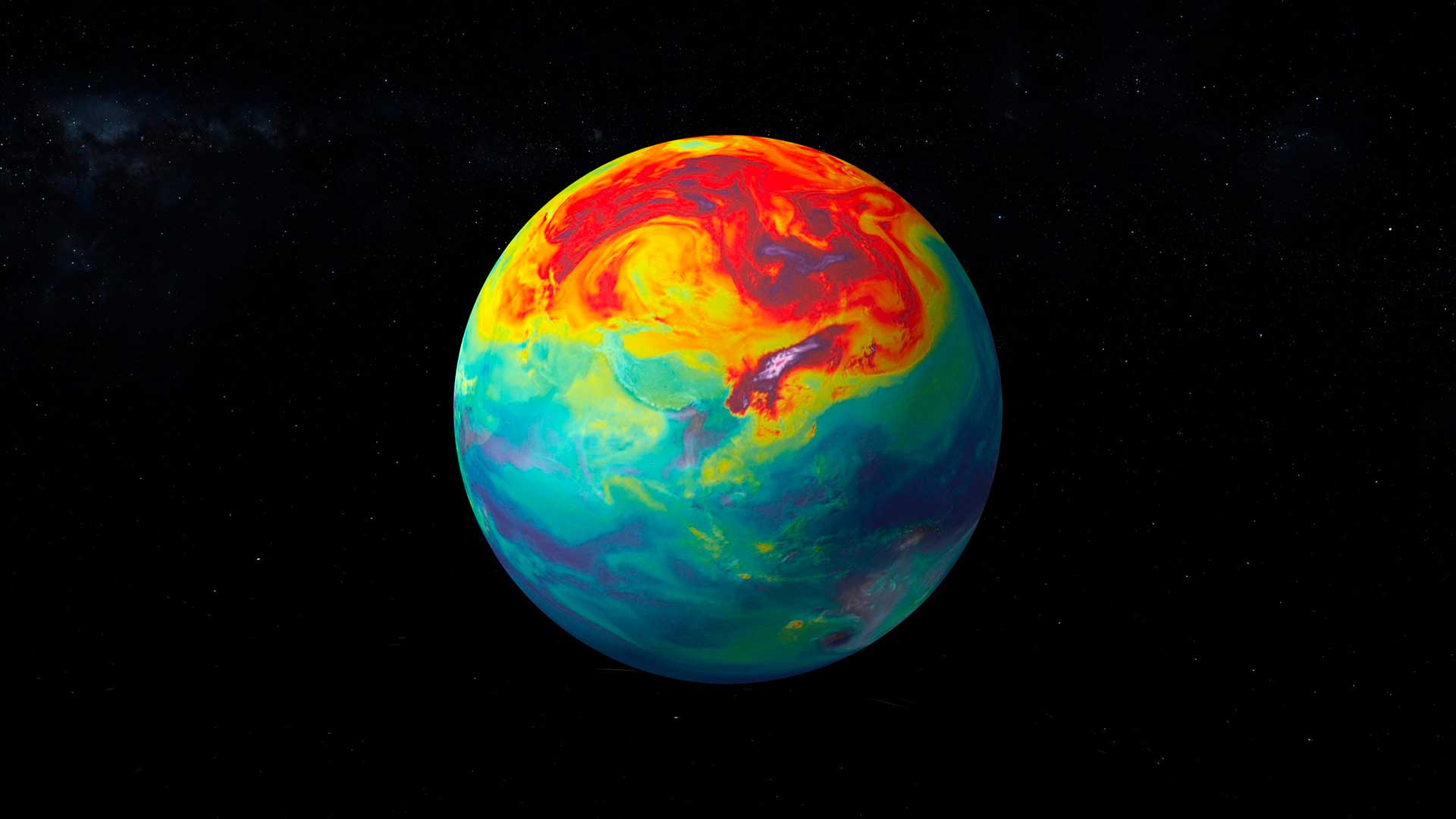

Con la pubblicazione da parte del governo britannico di test per nuove leggi sull’IA, i governi e i blocchi commerciali globali stanno ora implementando i loro quadri normativi. Inoltre, questa iniziativa si aggiunge agli sforzi globali per regolamentare l’IA. Sebbene l’approccio più cauto del Regno Unito contrasti con l’EU AI Act, è chiaro che la regolamentazione, rigorosa o meno, sarà cruciale per garantire l’uso di dati di alta qualità. La regolamentazione favorirà la trasparenza, la responsabilità delle fonti e la condivisione dei dati tra le organizzazioni, assicurando l’equità dei modelli.

Tuttavia, la praticabilità della regolamentazione dell’IA presenta delle problematiche. In particolare, la definizione di IA ad alto rischio è ancora in discussione. Per questo motivo, la legge europea sull’IA sta cercando soluzioni credibili. Questa legislazione punta a rafforzare le norme sulla qualità dei dati e la responsabilità. I fornitori di IA dovranno garantire la conformità ai requisiti basati sul rischio, inclusa la registrazione dei dati e delle risorse di formazione, e un sistema di gestione della qualità dei dati.

Conclusione

Per le organizzazioni che utilizzano l’IA, è fondamentale implementare standard interni che rendano le persone responsabili dell’accuratezza dell’etichettatura dei dati e verifichino regolarmente eventuali errori o incongruenze. Promuovere standard elevati per la qualità dei dati e un’AI governance migliorerà l’accuratezza e l’equità dei modelli di IA, continuando a sfruttare i benefici di questa tecnologia emergente.