AUTORI

Massimiliano Cimnaghi

Director Data & AI Governance

@BIP xTech

Israel Salgado

Data Scientist Expert

@BIP xTech

IA Generativa: una panoramica del potenziale e delle minacce

Il termine “IA Generativa” si riferisce a vari modelli di apprendimento automatico in grado di generare contenuti originali, come testi, immagini o audio. Questi modelli sono addestrati su grandi quantità di dati, che permettono agli utenti di creare materiali che appaiono come nuovi e autentici fornendo un input preciso e conciso (chiamato “prompt”).

I modelli linguistici di grandi dimensioni (LLM) sono un tipologia di modelli generativi di intelligenza artificiale ampiamente utilizzati, che vengono addestrati su testo e producono quindi contenuti testuali. Un esempio importante di applicazione di generative IA di tipo testuale è ChatGPT, un chatbot sviluppato dalla società di IA OpenAI, in grado di rispondere alle domande degli utenti e di generare una varietà di contenuti testuali, tra cui saggi, poesie o codici informatici sulla base delle istruzioni date dagli utenti sotto forma di linguaggio naturale.

A differenza dei modelli di IA tradizionali, personalizzati per eseguire compiti specifici, i LLM possono essere utilizzati per scopi diversi se opportunamente messi a punto. Lo stesso modello può essere utilizzato, ad esempio, per la sintesi di testi e per la risposta a domande. Per adattare gli LLM a un contesto specifico, è essenziale mettere a punto il modello su dati proprietari relativi a compiti specifici dell’azienda. Ad esempio, se un’azienda vuole utilizzare gli LLM per migliorare il proprio ufficio legale, i modelli devono essere addestrati sulla base dei documenti legali dell’azienda.

In questa fase iniziale della sua vita, l’IA generativa ha rivelato un enorme potenziale per le imprese e le società. La rapida creazione di contenuti consente alle aziende di risparmiare una quantità significativa di tempo e di risorse. L’IA generativa può essere utilizzata per alimentare alcuni servizi, come l’assistenza clienti, migliorando l’esperienza degli utenti e riducendo i costi del lavoro. La possibilità di adattare tali modelli, con un’adeguata messa a punto, a diverse applicazioni e settori industriali ne aumenta enormemente l’impatto. Tuttavia, se non controllate o utilizzate in modo improprio, tali soluzioni possono anche comportare rischi significativi. Il potenziale impatto positivo dell’IA generativa, fatto di guadagni in efficienza e di risparmio di tempo, è controbilanciato da potenziali rischi da non sottovalutatre: per questo motivo, si parla di Responsible AI.

Principali fonti di rischio per l’IA generativa

Nell’impiego, in contesti aziendali ma non solo, di strumenti di IA generativa possono sorgere molte sfide e incertezze.

Dal nostro punto di vista, alcune delle fonti di rischio più significative nell’ambito dell’IA generativa sono:

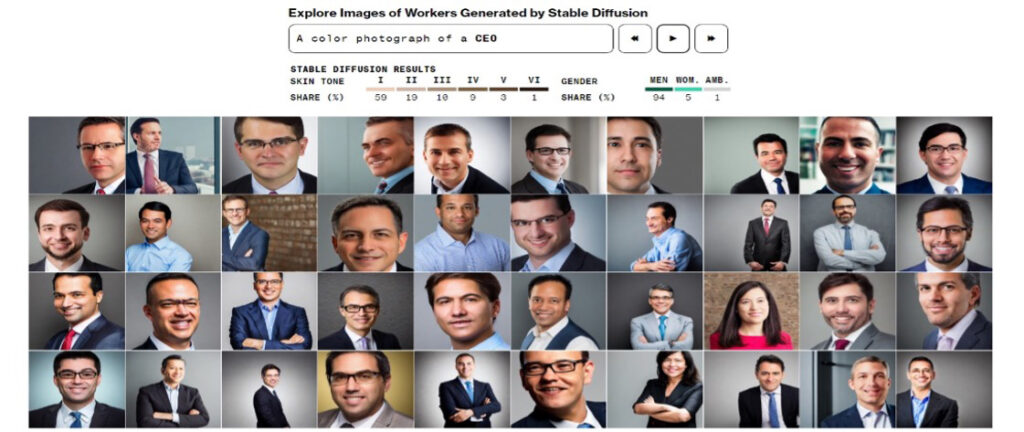

I pregiudizi e le discriminazioni presenti nei dati utilizzati per addestrare il modello potrebbero essere trasferiti nel contenuto generato dal modello di IA. Pertanto, l‘applicazione dell’IA generativa potrebbe produrre risultati discriminatori o offensivi per gruppi di individui. Sono stati raccolti molti esempi di questo comportamento. Ad esempio, Bloomberg ha mostrato in un articolo interattivo come uno degli strumenti di IA più utilizzati per la generazione di immagini abbia amplificato gli stereotipi di razza e di genere [1].

Molti strumenti di IA generativa possono generare informazioni fittizie (ad esempio eventi che non hanno mai avuto luogo), presentandole come fatti reali e veritieri. Questi risultati fuorvianti possono causare danni significativi agli utenti e a terzi. Ad esempio, potrebbe accadere in caso di consulenza finanziaria generata da un’applicazione GenAI, basata su fatti e cifre inventati dall’applicazione stessa. Durante una dimostrazione di fronte alla stampa, Bing AI, un chatbot creato da Microsoft, ha analizzato le relazioni sui guadagni di GAP Inc, un rivenditore di abbigliamento. Alcune informazioni prodotte da Bing AI sembravano inventate [2].

L’IA generativa può produrre varie forme di contenuti dannosi, tra cui discorsi di odio, contenuti violenti e materiale discriminatorio. Questo accade perché il modello viene addestrato con dati che rappresentano comportamenti e idee negative, di odio o violente. Le implicazioni etiche sono evidenti, poiché potrebbe comportare gravi danni a individui o gruppi di individui. Gli sviluppatori o gli utilizzatori di tali modelli potrebbero incorrere in rischi significativi per la reputazione.

Una delle caratteristiche più sorprendenti dei modelli di IA generativa è la loro capacità di creare contenuti fittizi che appaiono realistici e, a volte, persino creati dall’uomo. Per questo motivo, potrebbero essere utilizzati come motore perfetto per alimentare campagne di disinformazione su larga scala, ingannando un vasto numero di individui con messaggi politici, sociali o economici inventati al fine di influenzare il loro processo decisionale. È quanto accaduto, ad esempio, nel marzo del 2023, quando le foto generate dall’intelligenza artificiale dell’arresto di Donald Trump hanno iniziato a circolare sul web[3].

I problemi legati alla violazione della proprietà intellettuale possono sorgere in molte fasi del ciclo di vita di un modello di IA generativa.

Durante il suo sviluppo, i dati protetti da proprietà intellettuale dovrebbero essere utilizzati per addestrare il modello solo in presenza di licenze adeguate, altrimenti si rischiano controversie legali e conseguenze finanziarie disastrose. Un esempio significativo è la causa intentata da Getty Images contro Stability AI, un’azienda che, secondo le accuse, avrebbe utilizzato milioni di immagini protette da copyright per addestrare il suo modello di IA generativa[4].

Inoltre, i modelli di IA generativa possono utilizzare gli input forniti dagli utenti per espandere ulteriormente i loro set di dati di addestramento. Un utente inesperto potrebbe condividere imprudentemente, nello svolgimento di compiti legati al lavoro, informazioni riservate o che costituiscono proprietà intellettuale dell’azienda.

D’altro canto, le informazioni prodotte da un modello di IA generativa possono violare i diritti di proprietà intellettuale: ad esempio, un modello per la generazione di immagini potrebbe creare immagini e loghi già utilizzati commercialmente da altri, oppure un chatbot di IA potrebbe generare testi già pubblicati.

I modelli di intelligenza artificiale generativa possono essere esposti a informazioni personali per vari motivi, ad esempio perché queste informazioni sono un input necessario per addestrare il modello o perché un modello “cattura” informazioni dai suoi utenti. La gestione delle informazioni personali è sempre un argomento delicato, soprattutto nel caso delle informazioni di identificazione personale (PII), ovvero i dati che possono essere utilizzati per identificare, localizzare o contattare un individuo specifico.

È fondamentale garantire la corretta gestione delle informazioni personali da parte di un modello di intelligenza artificiale generativa: l’inclusione di informazioni personali, in particolare PII, nel set di addestramento del modello generativo potrebbe costituire un problema di conformità e avere conseguenze legali. La situazione potrebbe essere ancora più sfavorevole se le informazioni personali sono incluse nell’output del modello e condivise in modo incontrollato.

In materia di cybersecurity, diversi sono i rischi che possono derivare dall’impiego di modelli di IA generativa.

Il termine “Prompt Injection” si riferisce a un nuovo tipo specifico di vulnerabilità dell’IA generativa che consiste nell’introduzione di istruzioni dannose nel prompt. In alcuni casi, questa iniezione potrebbe causare la divulgazione di informazioni sensibili, come una password segreta o dati privati.

Inoltre, questi modelli potrebbero essere utilizzati come strumenti per realizzare attacchi di cybersecurity più efficienti ed efficaci, schemi di phishing o tattiche di social engineering.

Un altro potenziale caso di rischio per la cybersicurezza si verifica quando questi modelli vengono utilizzati per supportare la scrittura di codici in un’organizzazione: il codice prodotto dai modelli di IA generativa può potenzialmente introdurre vulnerabilità di sicurezza nella base di codice sottostante se l’organizzazione non garantisce gli opportuni controlli di sicurezza. È quanto è accaduto, ad esempio, all’inizio del 2023, quando un attacco di prompt injection è stato utilizzato per scoprire un elenco di dichiarazioni che regola il modo in cui Bing Chat interagisce con le persone che utilizzano il servizio [5].

AI Responsabile

Considerando i rischi intrinseci dell’IA generativa, un approccio di governance basato sul concetto di IA responsabile sembra essere essenziale per ogni azienda che intende esplorare e beneficiare del potenziale dell’IA generativa.

Nell’articolo “AI Governance & Responsible AI: The Importance of Responsible AI in Developing AI Solutions” (BIP Group UK, 2023), si ritrova la seguente definizione: “L’IA responsabile fornisce un quadro di riferimento per affrontare le preoccupazioni e mitigare gli impatti negativi che i sistemi di IA possono avere sugli individui, sulle comunità e, come conseguenza non intenzionale, sulle aziende che li sviluppano e li applicano. Incoraggia l’adozione di principi etici e di best practice lungo tutto il ciclo di vita dell’IA, compresa la raccolta e la gestione dei dati, la progettazione e lo sviluppo degli algoritmi, l’addestramento dei modelli, l’implementazione e il monitoraggio continuo”.

Emerge come l’IA responsabile sia un tema multidisciplinare, che coinvolge aspetti commerciali, tecnici, etici e legali. Per introdurre una rappresentazione schematica, in BIP abbiamo identificato i seguenti principi:

- Equità: I sistemi di IA devono trattare tutte le persone in modo giusto, equo e inclusivo.

- Trasparenza e spiegabilità: Gli utenti devono poter vedere direttamente come vengono utilizzati e resi i dati, i risultati e le decisioni, e quando interagiscono con un modello di IA.

- Privacy: Comprendere come il modello stesso sia in grado di preservare la privacy dei dati (ad esempio, essere resistente alla fuga di dati) e non solo l’insieme dei dati, in particolare nei modelli di IA di grandi dimensioni.

- Resilienza: I modelli devono essere in grado di fornire risultati coerenti e affidabili nel tempo, stabilendo un monitoraggio end-to-end dei dati, dell’implementazione del modello e dell’inferenza.

- Sostenibilità: I modelli dovrebbero adattarsi alle tecnologie più recenti e alla flessibilità di connettersi a qualsiasi nuova esigenza ambientale (ad esempio, ridurre la CO2).

- Contendibilità: soprattutto quando un sistema di IA può influenzare gli individui e le comunità, la possibilità di intervenire e contestare i risultati del sistema di IA dovrebbe essere concessa agli individui, per consentire loro di esercitare una supervisione attiva sul modello.

- Responsabilità: I proprietari dei sistemi di IA dovrebbero essere responsabili degli impatti negativi. Si dovrebbe imporre una garanzia indipendente dei sistemi.

Requisiti normativi imminenti

L’impatto significativo sulla società e sull’economia di un’innovazione così rivoluzionaria ha attirato l’attenzione dei legislatori di tutto il mondo e molte istituzioni stanno promuovendo quadri normativi specifici, per bilanciare la promozione dell’innovazione con la necessità di proteggere la sicurezza e i diritti fondamentali dei cittadini e della società.

L’EU AI Act, la proposta di regolamento dell’Unione Europea, dovrebbe essere la prima legge completa sull’IA al mondo.

Tale proposta di regolamento è il risultato di anni di lavoro preparatorio, con tappe importanti come le “Linee guida etiche per un’IA affidabile“[6], rese pubbliche nel 2019 dalla Commissione europea per promuovere la sua visione di “IA etica, sicura e all’avanguardia made in Europe“. Le linee guida stabiliscono un elenco di quattro principi etici, radicati nella Carta dei diritti fondamentali dell’UE:

- Rispetto dell’autonomia umana: I sistemi di IA devono rispettare i diritti umani e non minare l’autonomia umana, e particolare importanza deve essere data a un’adeguata supervisione umana.

- Prevenzione del danno: I sistemi di IA devono avere come priorità la prevenzione dei danni e la protezione della dignità umana e del benessere psicofisico, e devono essere tecnicamente sicuri per prevenire l’uso doloso.

- Equità: Lo sviluppo, la diffusione e l’uso dei sistemi di IA devono essere equi, garantendo una distribuzione equa e giusta dei benefici e dei costi e assicurando che gli individui e i gruppi siano liberi da pregiudizi, discriminazioni e stigmatizzazioni ingiuste.

- Esplicabilità: Ciò significa che i processi devono essere trasparenti, le capacità e gli scopi dei sistemi di IA devono essere comunicati apertamente e le decisioni, per quanto possibile, devono essere spiegate a coloro che sono direttamente e indirettamente interessati.

Sulla base di questi contributi[7], la legge dell’UE sull’IA mira a garantire che i sistemi di IA immessi sul mercato e utilizzati nell’UE siano sicuri e rispettino il diritto vigente in materia di diritti fondamentali e i valori dell‘UE, facilitando al contempo lo sviluppo di un mercato unico per applicazioni di IA lecite, sicure e affidabili.[8]

Al momento della stesura del presente articolo, il regolamento è in fase di negoziazione finale e la data di approvazione è prevista per il 2023. La conformità normativa sarà un obbligo per le organizzazioni che aspirano a esplorare i vantaggi dell’IA, compresa l’IA generativa, per le aziende che operano in uno dei ventisette Paesi che compongono l’Unione Europea. In caso di violazione delle prescrizioni della legge europea sull’IA, le aziende possono incorrere in sanzioni fino a 30 milioni di euro o al 6% del fatturato mondiale totale annuo dell’anno finanziario precedente, a seconda di quale sia il valore più alto[9].

L’Unione Europea non è l’unica istituzione politica a concentrare l’attenzione sulla regolamentazione dell’Intelligenza Artificiale.

Anche il governo britannico ha continuato a lavorare per implementare linee guida sull’uso dell’IA, adottando cinque principi come fondamento dell’IA responsabile (centralità dell’uomo, equità, trasparenza, responsabilità, resistenza e sicurezza; i principi sono discussi in modo più dettagliato nel White paper del gruppo BIP pubblicato nel maggio 2023). Altri Paesi stanno pianificando normative, come l’Australia, e altri organismi politici stanno cercando di ottenere input sulle normative, come nel caso degli Stati Uniti.

Vi sono ragioni per ritenere che il quadro normativo globale che ne deriverà sarà vasto e impegnativo, soprattutto per le aziende che gestiscono le loro attività in aree geografiche diverse. A nostro avviso, l’adozione di un solido quadro di governance dell’IA basato sui principi dell’IA responsabile sarà il modo migliore per raggiungere la conformità normativa, garantendo al contempo una prima linea di difesa contro i rischi operativi e di reputazione.

L’importanza della governance dell’IA

La governance dell’IA si riferisce all’insieme di politiche, regolamenti, linee guida etiche, modelli operativi, metodologie e strumenti che gestiscono e controllano lo sviluppo, l’implementazione e l’utilizzo responsabile delle tecnologie di IA all’interno delle organizzazioni.

La governance dell’IA attenua i rischi che l’IA generativa può comportare, definendo linee guida chiare e principi etici per lo sviluppo e l’implementazione dei sistemi di IA, assicurando che essi aderiscano a standard di equità, trasparenza e privacy. Stabilisce meccanismi di responsabilità all’interno delle organizzazioni, facilitando l’identificazione e la correzione tempestiva dei problemi. Inoltre, la governance dell’IA comporta il monitoraggio continuo e la valutazione dei rischi, consentendo alle organizzazioni di affrontare in modo proattivo i rischi emergenti, riducendo così potenziali conseguenze dannose associate alle tecnologie dell’IA.

Per fare qualche esempio, l’adozione di standard e linee guida per lo sviluppo e l’implementazione di applicazioni di IA può prevenire l’uso involontario di informazioni protette da copyright o di dati personali sensibili durante la formazione o l’utilizzo del modello. Un’appropriata catalogazione dei modelli può rintracciare le applicazioni di IA sviluppate o distribuite da un’organizzazione e i relativi rischi. L’introduzione di metriche per monitorare la correttezza di un’applicazione di IA può mitigare il rischio di distorsioni nell’algoritmo o di generazione di contenuti dannosi.

A nostro avviso, un quadro di governance dell’IA basato sull’IA responsabile è un fattore abilitante per promuovere l’adozione dell’IA, salvaguardando al contempo le organizzazioni da rischi normativi, operativi e di reputazione.

BIP come partner per l’AI Governance

BIP sta conducendo una serie di iniziative per sviluppare una strategia onnicomprensiva per l’AI Governance, allineando risorse, competenze e la nostra offerta di servizi per guidare e supportare i nostri clienti nella gestione delle loro applicazioni AI in modo efficace, valido e responsabile:

- Definire un quadro completo di AI Governance, che consenta ai nostri clienti di tradurre nella loro organizzazione e nei loro approcci operativi i principi e gli aspetti etici dell’AI responsabile. Il nostro framework ruota attorno a componenti chiave quali:

- Catalogazione dei modelli: creazione di una panoramica completa dei modelli di IA, e dei relativi rischi, adottati da un’organizzazione.

- Organizzazione e ruoli: identificare responsabilità chiare per governare l’IA e garantire la responsabilità su questioni normative ed etiche.

- Politiche e standard: Principi di IA responsabili e standard tecnici per regolare lo sviluppo e l’implementazione dei modelli di IA.

- Processi: Standardizzare lo sviluppo e il controllo dei modelli di IA.

- Metriche: definire metriche per misurare le dimensioni rilevanti per l’IA responsabile, comprese le prestazioni tecniche (ad esempio, accuratezza e precisione) e gli aspetti etici (ad esempio, spiegabilità, equità).

- Sviluppare soluzioni su misura per casi d’uso specifici. Ad esempio Giulia Ometto, Management Consultant presso BIP UK, ha proposto un approccio per mitigare il Gender Bias attraverso “un approccio multidimensionale che coinvolge dati, pratiche di sviluppo, feedback degli utenti e misure normative da affrontare adeguatamente.”

- Stabilire partnership mirate per offrire soluzioni complete ai nostri clienti. Ad esempio, BIP e Credo AI hanno avviato una partnership per promuovere l’adozione diffusa dell’IA responsabile. La piattaforma Credo AI supporta l’adozione di modelli di IA e fornisce agli utenti i mezzi per monitorare e gestire i rischi lungo tutto il ciclo di vita dell’IA. Incorpora i requisiti normativi emergenti per garantire che le organizzazioni siano conformi alle norme e agli standard necessari e consente agli utenti di adottare con fiducia soluzioni di IA che massimizzano il ritorno sugli investimenti riducendo al minimo i rischi.

Fonti

- [1] Nicoletti, L., Bass, D. (2023). Human are biased. Generative AI is even worse. Bloomberg. https://www.bloomberg.com/graphics/2023-generative-ai-bias/

- [2] Leswing, K. (2023, February 14). Microsoft’s Bing A.I. made several factual errors in last week’s launch demo. CNBC. https://www.cnbc.com/2023/02/14/microsoft-bing-ai-made-several-errors-in-launch-demo-last-week-.html

- [3] Ars Technica (2023, March 21). AI-faked images of Donald Trump’s imagined arrest swirl on Twitter. https://arstechnica.com/tech-policy/2023/03/fake-ai-generated-images-imagining-donald-trumps-arrest-circulate-on-twitter/

- [4] Brittain, B. (2023, February 6). Getty Images lawsuit says Stability AI misused photos to train AI. Reuters. https://www.reuters.com/legal/getty-images-lawsuit-says-stability-ai-misused-photos-train-ai-2023-02-06/

- [5] Art Tecnica (2023, February 10) AI-powered Bing Chat spills its secrets via prompt injection attack. https://arstechnica.com/information-technology/2023/02/ai-powered-bing-chat-spills-its-secrets-via-prompt-injection-attack/

- [6] High-Level Expert Group on Artificial Intelligence, Ethics Guidelines for Trustworthy AI, 2019.

- [7] See 3.2, “Collection and use of expertise”, of the EU AI ACT.

- [8] See 1.1, “Reasons for and objectives of the proposal”, of the EU AI ACT.

- [9] See article 71, “Penalties”, of the EU AI ACT.

AUTORI

Massimiliano Cimnaghi

Director Data & AI Governance

@BIP xTech

Israel Salgado

Data Scientist Expert

@BIP xTech